五角大樓AI倫理準則能否阻止機器人毀滅人類?

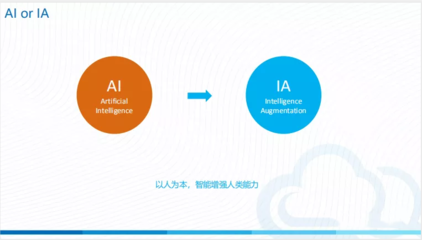

隨著人工智能技術(shù)的迅猛發(fā)展,有關(guān)機器人可能威脅人類生存的討論日益激烈。五角大樓為此制定了五條人工智能倫理準則:負責任、可追溯、可靠、可治理、可控。這些準則旨在確保軍事領域AI系統(tǒng)的安全性與可控性。

在人工智能應用軟件開發(fā)過程中,這些準則要求系統(tǒng)必須明確責任歸屬,開發(fā)過程全程可追溯,確保算法決策的可靠性,建立有效的監(jiān)管機制,并保留人類對關(guān)鍵決策的最終控制權(quán)。從技術(shù)角度看,這涉及多層次的防護設計:在軟件架構(gòu)層面嵌入倫理約束,通過測試驗證系統(tǒng)行為的可預測性,以及設置人工否決機制。

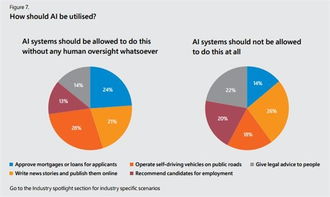

這些準則的實際效力面臨挑戰(zhàn)。AI系統(tǒng)的復雜性可能導致不可預見的涌現(xiàn)行為;各國在AI軍事化應用上存在競爭,可能削弱倫理約束;民用AI技術(shù)的擴散增加了監(jiān)管難度。專家指出,真正有效的防護需要全球協(xié)作、持續(xù)的技術(shù)迭代和健全的法律體系共同作用。

當前,在自動駕駛、醫(yī)療診斷等民用領域,類似的倫理準則已產(chǎn)生積極影響。但在應對極端假設的‘機器人毀滅人類’場景時,現(xiàn)有措施仍顯不足。未來需要更先進的價值對齊技術(shù)、更強大的安全驗證體系,以及跨學科的風險評估機制,才能構(gòu)建真正可靠的人工智能防護網(wǎng)。

如若轉(zhuǎn)載,請注明出處:http://www.plujtyyaa.cn/product/26.html

更新時間:2026-01-08 08:39:25